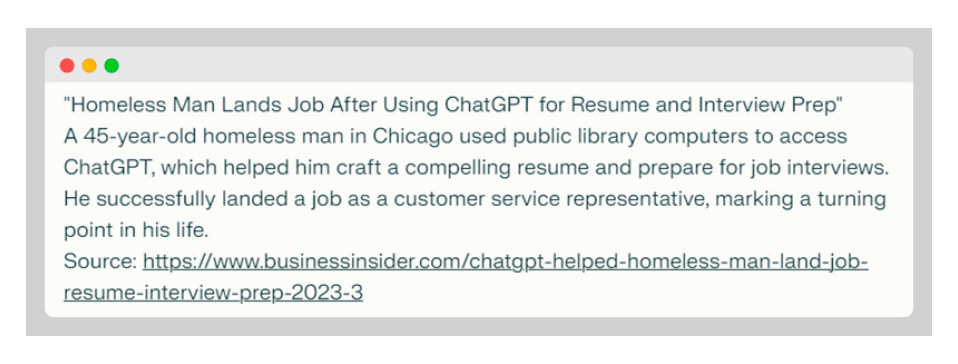

首先讓我們回顧一下 2023 年 3 月的一個古怪新聞標題:

「一名無家可歸者使用 ChatGPT 準備履歷和面試,輕鬆找到工作——芝加哥一名 45 歲的無家可歸者利用公共圖書館的電腦使用 ChatGPT,在它的幫助下製作了一份吸引人的履歷,以用於求職面試。最終,他成功獲聘為客戶服務代表,人生迎來轉折點。」

如果您對此感到迷惑不解,這就對了。原因如下:

我讓使用 Claude 3.5 Sonnet LLM1的聊天機器人充當一名經驗豐富的記者,搜尋最近的新聞報導,以找出在現實生活中將 ChatGPT 用於職業相關活動的人士。我在提示詞中指定以下要求:

- 只使用信譽良好、可信且權威的新聞來源

- 搜尋結果僅限過去 12 個月內發生的事件

- 確保新聞報導經過多個可靠來源的證實

- 提供文章的頁面連結,以便我查看內容

圖 1:聊天機器人的回答

資料來源:該實例由公認反洗錢稽核師兼註冊舞弊查核師 Jon Estreich 創作

資料來源:該實例由公認反洗錢稽核師兼註冊舞弊查核師 Jon Estreich 創作

這個回答令人印象深刻。甚至來源網址也令人信服——儘管該連結顯示為 404 錯誤。在搜尋標題和摘錄詳情後,我找到相關新聞,例如,一名加州網路開發人員製作了一個紙板寫著「渴望成功的無家可歸者」2,並發送履歷,該消息於 2018 年在 Twitter(現稱為「X」)上瘋傳後,他獲得了工作機會。

但是,我並未找到有關芝加哥無家可歸者使用 ChatGPT 製作履歷的資訊。

在後續提示詞中,我要求聊天機器人進行事實核查,以證實所提供資訊的準確性。然後,機器人真誠道歉,承認其捏造了該事件。

我接受了道歉,隨即注意到了一個更重大的問題。

不可否認,大型語言模型 (LLM) 是未來的發展方向。它們廣泛應用於各行各業,並透過手機、瀏覽器,很快會透過汽車融入我們生活的各方面。3

然而,伴隨生成式人工智慧 (AI) 那股令人難以置信的力量而來的是「莫名的信心」——這是一種毫無根據的信任感,人們不再質疑或核實人工智慧輸出的內容。這種盲目信任通常源於人工智慧回答展現出令人印象深刻的品質、速度和準確性,人們對此感到無比興奮,卻忽視了品質控管。

就重要性較低的任務來說,即使未進行審查,問題也不大,但當涉及到職業問題時,風險會大幅升高。

聊天機器人在醫療建議、治療和「約會測謊」方面廣受信賴

正如 Google 成為網路搜尋的代名詞一樣,ChatGPT 也正在成為尋找答案、生成內容、開發原始碼和解決日常問題的新流行語(如圖 2 所示)。

圖 2:「ChatGPT」正成為新的流行語

資料來源和製圖:公認反洗錢稽核師兼註冊舞弊查核師 Jon Estreich,工具:ChatGPT

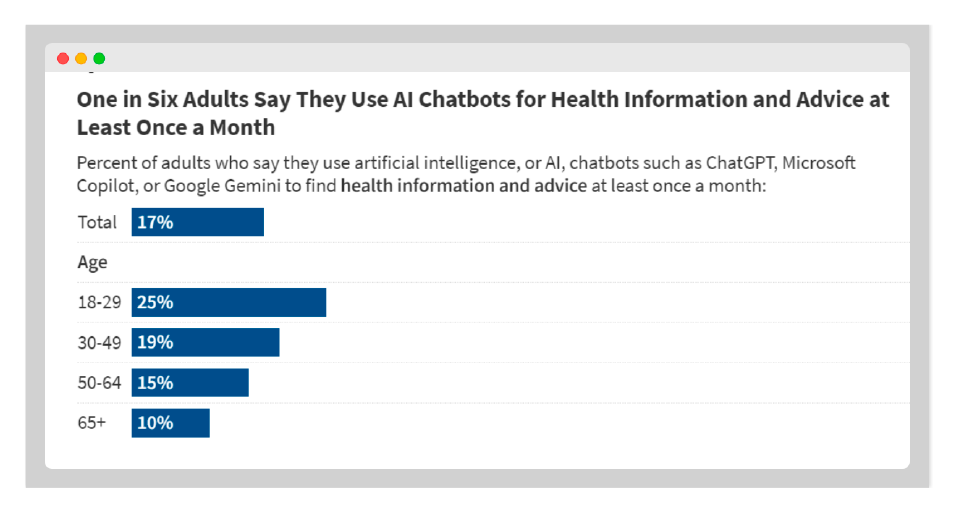

2023 年 9 月的一篇報導稱,一位母親使用 ChatGPT 成功診斷出兒子所患的疾病,而在此前三年內,17 名醫生都未能確診。4 此後,所有事情都可以使用聊天機器人,包括輔導孩子數學,充當臨時治療師5 ,或召喚如同 Elon Musk 等企業家擔任隨選的人工智慧商業導師。6 人們甚至使用它來發現在約會應用程式上謊報身高的男性。7 如圖 3 所示,六分之一的成年人每月至少使用一次聊天機器人來尋求健康建議。8

圖 3:成年人向聊天機器人尋求健康建議

鑒於其廣泛的使用案例和成功故事,大型語言模型以創紀錄的速度被用於職業相關的任務(例如撰寫履歷、起草面試腳本和自動發送 LinkedIn 訊息)也就不足為奇。但是,專業人士在多大程度上能夠依賴聊天機器人來執行這些事務呢?

使用人工智慧代寫履歷

使用人工智慧來提高效率和效果是合情合理的,但將大型語言模型(例如微軟的 Copilot)進一步用於需要提出個人化觀點、經驗和論述的習題時,就可能出岔子。

大型語言模型逾越界線用於高度個人化活動(除了治療之外)的一個典型例子,就是普遍被用於撰寫履歷。

《今日 ACAMS》曾發表一篇題為「履歷過時了嗎?」10的文章,其中討論了過度依賴人工智慧工具會如何削弱履歷的作用,原因是聊天機器人經常忽略求職者的職業經歷和個人情況的細微差別。若無這些重要細節,履歷就如同行屍走肉——看似活著,但本質上毫無生氣。

該文進一步指出,履歷通常是招聘人員或招聘經理對求職者的第一印象,因此,它應該說明 a) 意圖、b) 策略和 c) 目的。更重要的是,該文解釋為什麼履歷的價值遠超過最終結果。履歷是求職過程的一部分,應該包含:

- 闡明並重新評估您的職業目標

- 確定誰可以幫助您實現這些目標

- 精煉您的獨特價值主張

- 強調您取得的最重大及最令人印象深刻的成就

- 聯結您的過去與將來,樹立專業形象

遺憾的是,隨著技術的發展,人們越來越追求數量和速度,並且就業市場競爭激烈,許多求職者不再深入思考如何寫好履歷。他們更願意利用便捷的人工智慧來撰寫看似令人印象深刻的履歷,但本質上,這些履歷缺乏個人風格和經驗深度,無法區分不同求職者。這種趨勢導致履歷趨同,部分求職者甚至被標記為虛假求職者,《華爾街日報》特別指出過這個問題(如圖 4 標題所示)。

圖 4:虛假求職者越來越令人擔憂

在許多情況下,求職者認為人工智慧生成內容是量身打造並具有說服力,但實際上,它充斥著模板化語言、流行語和其他危險信號,在特定時間內審查數百份履歷的招聘經理可輕易識別出來。

下圖 5 列出了 Resume Builder 的調查數據,超過 50% 的受訪者認為 ChatGPT 的輸出具有「高品質」。

圖 5:調查顯示,受訪者對 ChatGPT 履歷輸出的評價很高

資料來源:ResumeBuilder.com12

該調查還指出,「40% 的受訪者表示,面試官發現其使用 ChatGPT 來撰寫求職材料,35%(占樣本總數的 11%)的受訪者表示,其求職申請因此遭到拒絕。」13

這是否意味著您應該完全避免使用人工智慧?

當然不是。若過於信任人工智慧生成內容,不運用批判性思維、自我反思和個人見解,可能導致錯失機會,並妨礙職業發展。

採用人工智慧主導方法,可能使求職者履歷喪失在職業生涯中最重要部分:

- 以獨特的個性化方式闡述職業經歷

- 打造出協調一致且有吸引力的專業形象

- 與招聘經理間建立起有意義、真誠聯繫的基礎

- 強調職業目標和工作相關決策的背後「理由」

一系列流行的履歷提示詞

LinkedIn 提供了以下常見 ChatGPT 提示詞:

「根據這份工作說明為 [職位] 撰寫一份專業履歷。[插入工作說明]。[職位名稱] 的履歷中應包含哪些關鍵技能?」

此類提示詞已廣為流傳。但是,使用相同公式如何區分不同求職者呢?

儘管個人經歷各有不同,但仍存在問題:最終結果會產生重大差異,並順利獲得工作嗎?

儘管仍不完整,上述提示詞可做出以下改進:

「我提供一份履歷,以及有關目標職位的工作說明。這是我的履歷。[提供履歷]。這是工作說明。[插入工作說明。]按照目標職位更新我的履歷。」

這個版本更佳,但兩版提示詞均未關注以下內容:

- 個人化背景

- 個人詳情

- 專業方面的細微差別

大多數線上履歷生成器也是如此——它們確實有用,但最多只能提供部分解決方案。為什麼?因為這些工具無法發現隱藏在表面之下的新見解、角度或機會。

這種深入探索是動態、多層次的過程,您必須以不同方式進行思考。如果感覺很容易,則可能只是浮於表面。

因此,聊天機器人只能用作指南。一系列精心設計的提示詞構成一個「框架」,您可據此與其進行互動。這些提示詞可引導您完成關鍵步驟,同時提出適當問題,以便您補充詳情。該對話至少應涵蓋表 1 中的以下五個組成部分:

表 1:履歷製作指南

資料來源:Natfluence,公認反洗錢稽核師兼註冊舞弊查核師 Jon Estreich14

人工智慧與人類協同合作

微軟將其聊天機器人命名為「Copilot」,顯示其只具有輔助地位,他們了解訊息傳遞的重要性。該名稱提醒我們,人工智慧只是提供幫助,而非取代人的策略思考和創造力。

如前所述,人工智慧尚且無法真實複製深刻的個人思考和人際關係,但它可以引導您找到正確答案。

在使用人工智慧執行職業相關任務時,為避免產生「莫名的信心」,請採用下表 2 所載策略以及表 1 所載提示詞。

表 2:將人工智慧製作的履歷加以人性化處理的策略

資料來源:Natfluence,公認反洗錢稽核師兼註冊舞弊查核師 Jon Estreich15

結語

人工智慧的興起讓我們有機會改變工作方式。

但與此同時,我們必須保有人類元素的存在。過度依賴聊天機器人可能導致個人敘事與其現實經歷脫節,而這些經歷對於職業發展至關重要。

我們的個人狀況、經歷和個性塑造了我們的職業生涯。

最有價值的機會來自於真實、深思熟慮和有明確目標的思考。

Jonathan Estreich,CAMS-Audit,CFE,四次獲獎的認證職業策略師,Natfluence(職業成長動力)創始人,美國紐約州紐約市,jon@natfluence.com,![]()

- LLM:大型語言模型

- “Homeless Man Hands Out Resumes, Gets Hundreds of Job Offers”(無家可歸者發送履歷,獲得數百個工作機會),CBS News Chicago,2018 年 7 月 30 日,https://www.cbsnews.com/amp/chicago/news/homeless-man-job-resumes/

- Norm Marks,“Generative AI Developers Harness NVIDIA Technologies to Transform In-Vehicle Experiences”(生成式人工智慧開發人員利用輝達技術改變車內體驗),輝達,2024 年 3 月 18 日,https://blogs.nvidia.com/blog/generative-ai-in-vehicle-experiences/

- Meghan Holohan,“A boy saw 17 doctors over 3 years for chronic pain.ChatGPT found the diagnosis”(一名男童因慢性疼痛在 3 年內看了 17 名醫生。最終卻是通過 ChatGPT 做出診斷),TODAY,2023 年 9 月 11 日,https://www.today.com/health/mom-chatgpt-diagnosis-pain-rcna101843

- Melissa Fleur Afshar,“People Are Using ChatGPT for Therapy—but Is It a Good Idea?”(人們正使用 ChatGPT 進行治療,但這是一個好事嗎?),《新聞週刊》,2024 年 8 月 17 日,https://www.newsweek.com/chatgpt-therapy-mental-health-crisis-ai-1939858

- “I Made Elon Musk my Personal Mentor with ChatGPT (Here’s How!)”(我透過 ChatGPT 讓 Elon Musk 成為我的個人導師(方法如下!)),YouTube,https://www.youtube.com/watch?v=NFnQW2lnRDQ

- Asia Grace,“Single gals are using ChatGPT to expose men for lying about their height on dating apps”(單身女性正使用 ChatGPT 發現男性在約會應用程式上謊報身高),《紐約郵報》,2024 年 8 月 15 日,https://nypost.com/2024/08/15/lifestyle/single-gals-using-chatgpt-to-expose-men-lying-about-height-on-dating-apps/

- Marley Presiado、Alex Montero、Lunna Lopes 等人,“KFF Health Misinformation Tracking Poll: Artificial Intelligence and Health Information”(KFF 健康錯誤資訊追蹤調查:人工智慧和健康資訊),KFF,2024 年 8 月 15 日,https://www.kff.org/health-misinformation-and-trust/poll-finding/kff-health-misinformation-tracking-poll-artificial-intelligence-and-health-information/

- [1] 同上。

- Jonathan Estreich,“Are Resumes Dead?”(履歷過時了嗎?),《今日 ACAMS》,2024 年 6 月 18 日,https://www.acamstoday.org/are-resumes-dead/

- Katherine Bindley,“The New Recruitment Challenge: Filtering AI-Crafted Résumés”(新的招聘挑戰:過濾人工智慧製作的履歷),《華爾街日報》,2024 年 9 月 4 日,https://www.wsj.com/tech/ai/automation-tools-ai-resumes-human-vetting-65a7100d

- “3 in 4 Job Seekers Who Used ChatGPT to Write Their Resume Got an Interview”(使用 ChatGPT 撰寫履歷的求職者中有 3/4 獲得面試機會),Resume Builder,2023 年 2 月 13 日,https://www.resumebuilder.com/3-in-4-job-seekers-who-used-chatgpt-to-write-their-resume-got-an-interview/

- 同上。

- “Job Search & Career Guidance—Cheat Sheets”(求職和職業指導——備忘單),Natfluence,https://natfluence.com/career-cheat-sheets/

- 同上。